אני מפחד. מאוד מפחד.

מעקב וצנזורה ברחבי האינטרנט, המתאפשרים על ידי כוח החישוב העצום הבלתי נתפס של בינה מלאכותית (AI), כאן.

זו לא דיסטופיה עתידנית. זה קורה עכשיו.

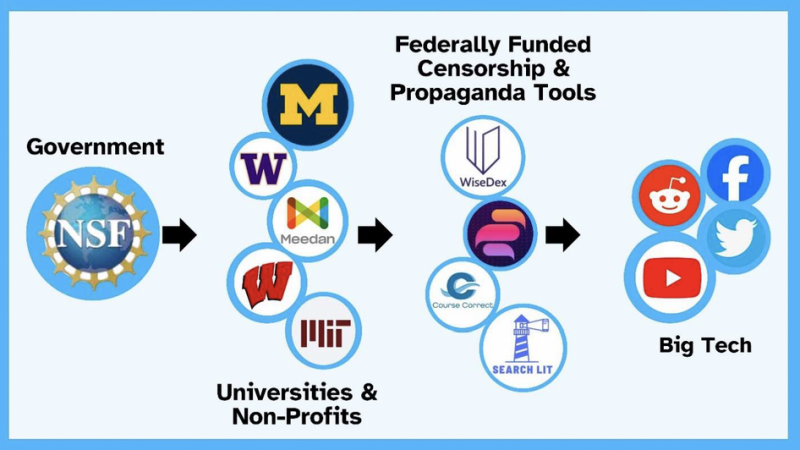

סוכנויות ממשלתיות עובדות עם אוניברסיטאות ועמותות כדי להשתמש בכלי בינה מלאכותית כדי לפקח ולצנזר תוכן באינטרנט.

זה לא פוליטי או מפלגתי. לא מדובר על דעה או רעיון מסוים.

מה שקורה הוא שכלי חזק מספיק כדי לפקח על כל מה שנאמר ונעשה באינטרנט (או חלקים גדולים ממנו) הופך לזמין לממשלה כדי לפקח על כולנו, כל הזמן. ועל סמך הניטור הזה, הממשלה - וכל ארגון או חברה שהממשלה שותפה איתם - יכולה אז להשתמש באותו כלי כדי לדכא, להשתיק ולסגור כל דיבור שהיא לא אוהבת.

אבל זה לא הכל. באמצעות אותו כלי, הממשלה ושותפיה הציבוריים-פרטיים, ה"לא-ממשלתיים" (חשבו למשל: ארגון הבריאות העולמי, או מונסנטו) יכולים גם לסגור כל פעילות המקושרת לאינטרנט. בנקאות, קנייה, מכירה, לימוד, למידה, אירוח, חיבור אחד לשני - אם ה-AI הנשלט על ידי הממשלה לא אוהב את מה שאתה (או הילדים שלך!) אומרים בציוץ או במייל, הוא יכול לסגור את כל זה עבור אתה.

כן, ראינו את זה בקנה מידה מאוד מקומי ופוליטי עם, למשל, נהגי המשאיות הקנדיים.

אבל אם חשבנו שפעילות מסוג זה לא יכולה, או לא תתרחש, בקנה מידה לאומי (או אפילו מפחיד יותר - עולמי), עלינו להתעורר כבר עכשיו ולהבין שהיא מתרחשת, וייתכן שהיא לא ניתנת לעצירה.

מסמכים חדשים מראים בינה מלאכותית במימון ממשלתי המיועדת לצנזורה מקוונת

ועדת המשנה הנבחרת של בית ארה"ב לנשק של הממשלה הפדרלית הוקמה בינואר 2023 "כדי לחקור עניינים הקשורים לאיסוף, ניתוח, הפצה ושימוש במידע על אזרחי ארה"ב על ידי סוכנויות הרשות המבצעת, לרבות האם מאמצים כאלה אינם חוקיים, לא חוקתיים או לא אתיים בדרך אחרת".

לרוע המזל, עבודת הוועדה נתפסת, אפילו על ידי חבריה, כפוליטית בעיקרה: מחוקקים שמרנים חוקרים את מה שהם תופסים כהשתקת קולות שמרניים על ידי סוכנויות ממשלתיות בעלי נטייה ליברלית.

אף על פי כן, בחקירותיה חשפה ועדה זו כמה מסמכים מדהימים הקשורים לניסיונות הממשלה לצנזר את נאומם של אזרחים אמריקאים.

למסמכים הללו יש השלכות מכריעות ומחרידות על כל החברה.

בדוח הביניים של ועדת המשנה, מתאריך 5 בפברואר 2024, מסמכים מראים שקבוצות אקדמיות ועמותות מציגות לסוכנות ממשלתית תוכנית להשתמש ב"שירותי מידע מוטעה" של AI כדי לצנזר תוכן בפלטפורמות אינטרנט.

באופן ספציפי, אוניברסיטת מישיגן מסבירה לקרן הלאומית למדע (NSF) שהכלים המופעלים על ידי AI הממומנים על ידי ה-NSF יכולים לשמש כדי לעזור לפלטפורמות מדיה חברתית לבצע פעילויות צנזורה מבלי להצטרך למעשה לקבל את ההחלטות על מה צריך לצנזר.

כך מוצג הקשר בדוח של ועדת המשנה:

להלן ציטוט ספציפי המוצג בדוח ועדת המשנה. זה מגיע מ"הערות הדובר מההצעה הראשונה של אוניברסיטת מישיגן לקרן הלאומית למדע (NSF) על הכלי WiseDex שלה, הממומן על ידי NSF, המופעל על ידי AI." ההערות נמצאות בתיק בוועדה.

שירות המידע השגוי שלנו מסייע לקובעי מדיניות בפלטפורמות שרוצים...לדחוף אחריות על שיפוטים קשים למישהו מחוץ לחברה...על ידי החצנה של האחריות הקשה של הצנזורה.

זוהי אמירה יוצאת דופן בכל כך הרבה רמות:

- זה משווה במפורש "שירות מידע מוטעה" לצנזורה.

זוהי משוואה מכרעת, מכיוון שממשלות ברחבי העולם מתיימרות להיאבק במידע מוטעה מזיק כאשר למעשה הן העברת הצעות חוק צנזורה ענקיות. ה הכריז WEF "אינפורמציה שגויה ודיסאינפורמציה" הם "הסיכונים הגלובליים החמורים ביותר" בשנתיים הקרובות, מה שאומר כנראה שהמאמצים הגדולים ביותר שלהם ילכו לצנזורה.

כאשר קבלן ממשלתי מצהיר במפורש שהוא מוכר "שירות מידע מוטעה" המסייע לפלטפורמות מקוונות "להחצין את הצנזורה" - שני המונחים מוכרים כניתנים להחלפה.

- זה מתייחס לצנזורה כ"אחריות".

במילים אחרות, היא מניחה שחלק ממה שהפלטפורמות צריכות לעשות הוא צנזורה. לא להגן על ילדים מפני טורפי מין או אזרחים חפים מפשע מפני מידע שגוי - פשוט צנזורה טהורה ופשוטה.

- היא קובעת שתפקידה של AI הוא "להחצין" את האחריות לצנזורה.

הפלטפורמות הטכנולוגיות לא רוצות לקבל החלטות צנזורה. הממשלה רוצה לקבל את ההחלטות האלה אבל לא רוצה שיראו אותה כצנזורה. כלי הבינה המלאכותית מאפשרים לפלטפורמות "להחצין" את החלטות הצנזורה ולממשלה להסתיר את פעילות הצנזורה שלה.

כל זה צריך לשים קץ לאשליה שמה שממשלות ברחבי העולם מכנות "נגד מידע מוטעה ודיבורי שטנה" אינו צנזורה ישירה.

מה קורה כאשר צנזורה בינה מלאכותית מיושמת במלואה?

בידיעה שהממשלה כבר משלמת עבור כלי צנזורה בינה מלאכותית, עלינו לכרוך את דעתנו במה שזה כרוך.

אין מגבלות כוח אדם: כפי שמציין דו"ח ועדת המשנה, המגבלות על צנזורה מקוונת ממשלתית כללו עד כה את המספר הגדול של בני אדם שנדרשו לעבור על אינסוף תיקים ולקבל החלטות צנזורה. עם AI, כמעט אף אדם לא צריך להיות מעורב, וכמות הנתונים שניתן לפקח עליה יכולה להיות עצומה כמו כל מה שמישהו אומר בפלטפורמה מסוימת. כמות הנתונים הזו אינה מובנת למוח אנושי בודד.

אף אחד לא אחראי: אחד ההיבטים המפחידים ביותר של צנזורה בינה מלאכותית הוא שכאשר בינה מלאכותית עושה זאת, אין אדם או ארגון - בין אם זה הממשלה, הפלטפורמות או האוניברסיטה/המלכ"רים - שאחראי למעשה על הצנזורה. בתחילה, בני אדם מאכילים את כלי הבינה המלאכותית בהוראות לאילו קטגוריות או סוגי שפה לצנזר, אבל אז המכונה ממשיכה ומקבלת את ההחלטות של כל מקרה לגופו בעצמה.

אין לפנות לתלונות: ברגע שה-AI ישוחרר עם קבוצה של הוראות צנזורה, היא תטאטא מיליוני נקודות מידע מקוונות ותפעיל פעולות צנזורה. אם אתה רוצה להתמודד עם פעולת צנזורה בינה מלאכותית, תצטרך לדבר עם המכונה. אולי הפלטפורמות יעסיקו בני אדם כדי להגיב לפניות. אבל למה שהם יעשו את זה, כשיש להם בינה מלאכותית שיכולה להפוך את התגובות האלה לאוטומטיות?

אין הגנה לצעירים: אחת הטענות של הצנזורה הממשלתית היא שעלינו להגן על ילדינו מפני מידע מקוון מזיק, כמו תוכן שהופך אותם לאנורקטיים, מעודד אותם להתאבד, הופך אותם לטרוריסטים של דאעש וכו'. גם מניצול מיני. כל אלה הם נושאים רציניים שראויים לתשומת לב. אבל הם אינם מסוכנים כמעט למספר עצום של צעירים כמו צנזורה בינה מלאכותית.

הסכנה הנשקפת מצנזורה בינה מלאכותית חלה על כל הצעירים שמבלים זמן רב באינטרנט, כי זה אומר שניתן לנטר את הפעילויות והשפה המקוונת שלהם ולהשתמש בהם נגדם - אולי לא עכשיו, אבל בכל פעם שהממשלה מחליטה ללכת אחרי סוג מסוים של שפה או התנהגות. זוהי סכנה הרבה יותר גדולה למספר גדול בהרבה של ילדים מאשר הסכנה הנשקפת מכל תוכן ספציפי, מכיוון שהיא מקיפה את כל הפעילות שהם עורכים באינטרנט, הנוגעת כמעט בכל היבט של חייהם.

הנה דוגמה להמחשת סכנה זו: נניח שהמתבגר שלך משחק המון משחקי וידאו אינטראקטיביים באינטרנט. נניח שבמקרה הוא מעדיף משחקים שעוצבו על ידי חברות סיניות. אולי הוא גם צופה באחרים משחקים במשחקים האלה, ומשתתף בצ'אטים ובקבוצות דיון על אותם משחקים, שבהם משתתפים גם הרבה אזרחים סינים.

הממשלה עשויה להחליט בחודש הבא, או בשנה הבאה, שכל מי שעוסק רבות במשחקי וידאו בעיצוב סיני מהווה סכנה לדמוקרטיה. זה עלול לגרום לסגירת חשבונות המדיה החברתית של בנך או למנוע ממנו גישה לכלים פיננסיים, כמו הלוואות לקולג'. זה עשוי להיות כרוך גם בסימון שלו באתרי תעסוקה או היכרויות כמסוכן או לא רצוי. זה יכול להיות ששוללים לו דרכון או מוכנס לרשימת מעקב.

החיים של המתבגר שלך פשוט נעשו הרבה יותר קשים. הרבה יותר קשה מאשר אם הוא היה נחשף לסרטון גיוס של דאעש או לפוסט התאבדותי של TikTok. וזה יקרה בקנה מידה הרבה יותר גדול מזה ניצול מיני שהצנזורים משתמשים בהם כסוס טרויאני לנרמול הרעיון של צנזורה ממשלתית מקוונת.

שירותי צנזורה הניתנים למונטיזציה: כלי בינה מלאכותית בבעלות הממשלה יכול באופן תיאורטי לשמש גורם לא ממשלתי באישור הממשלה, ובברכת הפלטפורמות שרוצות "להחצין" את ה"אחריות" לצנזורה. אז בעוד שהממשלה עשויה להשתמש בבינה מלאכותית כדי לפקח ולדכא, נניח כדוגמה, סנטימנט אנטי-מלחמתי - חברה יכולה להשתמש בו כדי לפקח ולדכא, נניח כדוגמה, רגשות נגד מזון מהיר. הממשלה יכולה להרוויח הרבה כסף ממכירת השירותים של כלי הבינה המלאכותית לצד שלישי. הפלטפורמות יכולות גם לבקש קיצוץ. לפיכך, כלי צנזורה בינה מלאכותית יכולים להועיל לממשלה, לפלטפורמות הטכנולוגיות ולתאגידים פרטיים. התמריצים הם כל כך חזקים, שכמעט בלתי אפשרי לדמיין שהם לא ינוצלו.

האם נוכל להפוך מסלול?

אני לא יודע כמה סוכנויות ממשלתיות וכמה פלטפורמות משתמשות בכלי צנזורה של AI. אני לא יודע באיזו מהירות הם יכולים להגדיל.

אני לא יודע אילו כלים עומדים לרשותנו - מלבד העלאת המודעות וניסיון ללובי לפוליטיקאים ולהגיש תביעות כדי למנוע צנזורה ממשלתית ולהסדיר את השימוש בכלי AI באינטרנט.

אם למישהו יש רעיונות אחרים, זה הזמן ליישם אותם.

פורסם תחת א רישיון בינלאומי של Creative Commons ייחוס 4.0

עבור הדפסות חוזרות, נא להחזיר את הקישור הקנוני למקור מכון ברונסטון מאמר ומחבר.